歐盟工作小組提出回應人工智慧風險的一個取徑:可解釋人工智慧(XAI)

- 林宏達

- 2025年11月30日

- 讀畢需時 5 分鐘

歐洲數位教育中樞(European Digital Education Hub,EDEH)今年8月發表「可解釋人工智慧在教育」的政策文件(以下簡稱為報告),說明可解釋人工智慧在教育中的影響,以及如何促進人類對人工智慧的監視和共享責任,提供歐盟下屬的文化教育執行署參考(Bellas, et al., 2025 )。

什麼是可解釋人工智慧(Explainable Artificial Intelligence,XAI)呢?可解釋人工智慧是能夠解釋其決策和行為的人工智慧系統,使其內部運作可被人類理解。這項技術可及協助提升人類使用者的人工智慧素養,以及批判思考(圖一),進而降低人工智慧系統在決策過程中的主要風險,包括:

延續並放大資料中已存在的現有偏見,導致不公平或歧視性的結果(Fairness);

無法確定人工智慧造成的錯誤和傷害的責任是在演算法,還是特定的設計選擇(Accountability);

不透明和複雜的人工智慧的發展與決策過程(Transparency)。 (Chamola, et al., 2023; Camerio and Veloso, 2021)。

圖1

可解釋的人工智慧

圖示說明:傳統人工智慧與可解釋的人工智慧的差異在於人工智慧是否有解釋其如何運算出決策與行為。Note: Generated by artificial intelligence.

教育和職業訓練有關的人工智慧系統在歐盟人工智慧法案的風險分級中,屬於高風險級別。歐盟人工智慧法案界定,凡是對安全和基本權利可能有負面影響風險的人工智慧系統皆屬於高風險範疇。依據規範,這類人工智慧系統在被引進市場或是進入產品生命週期前,須符合這些一系列嚴格的要求。然而另一方面,人工智慧在教育領域中的發展的確可能帶來諸多好處,包括:對學習者提供個別化的學習經驗;對教育工作者協助其評鑑和備課等日常庶務;支持失能、多語言、和需要替代學習方式的學習者。若要在教育與職業訓練領域發展值得讓人信任,以人為中心的人工智慧系統,可解釋人工智慧是關鍵之一。為支持教育人工智慧系統的創新發展,符合倫理期待與法規要求。歐洲數位教育中樞的工作小組對可解釋人工智慧,發表這份報告,描述其在未來應用中,在教育角度上,如何發展人類在人工智慧系統中的主導動能。這份報告主要回應三個主題(Bellas, et al., 2025):

一、如何預視可解釋人工智慧在教育的未來發展,並為其引路?

可解釋人工智慧在教育的概念可以從教育、法制與科技三個範疇來下手,首先,在教育範疇的重要概念是科技與教育合如何整合,目前已知的整合模型包括較重視教師責任的SAMR,TPACK,以及近期提出著重制度與機構責任的SETI。其次,在法制範疇是以歐盟的價值取徑作為整合的基礎。具體而言,也就是以基礎權利作為人工智慧發展的依據。目前已知的法規依據包括歐盟人工智慧法案(The EU Artificial Intelligence Act),通用資料保護規則(General Data Protection Regulation),以及與其相關的法律規範。這些法規確立了風險、解釋,以及人類監控的原則和規範,以及法規或介入適用的時間和地點。在技術範疇上,人工智慧發展者的挑戰在於兼顧有效的技術發展和使用者本位的設計。其主題有二:解釋什麼,又如何解釋。

二、不同教育利害關係人對可解釋人工智慧的觀點以及著力點為何?

這個主題的前提是:複雜的解釋可能會對使用者的認知造成過度負擔,甚至過度佔用使用者的時間。報告中指出依據研究,視覺化的解釋最有效率。這樣的解釋應包括簡潔文字,視覺化,與口語表達。從設計的角度來看,有必要針對教育場域中不同利害關係人的角度切入,來思考不同位置的關注點,以及在問題被偵測到時,可以如何進行介入。報告中指出的利害關係人包括學習者、教師、課程規劃者、教育領導者、政策制定者、開發者。該報告並且提供兩個可能的場景來說明不同利害關係者的觀點以及可以介入的時間點。

三、學習者和教育者在可解釋人工智慧的發展與應用上需具備什麼能力呢?

對人工智慧的批判性思考,亦即知道何種人工智慧適用於何處,以及人工智慧的應用、發展和限制。此外報告也指出,在發展可解釋人工智慧的過程中,可能會產生這樣的問題:使用者可能會高估了解釋的重要性,而忽略了原本的問題是什麼。依據能力發展的方向和可能發生的問題,報告整理了相關法規,按不同學習層級,提出學習者和教育者可以培養的可解釋人工智慧能力。並進一步建議不同教育利害關係人可以採取的行動。

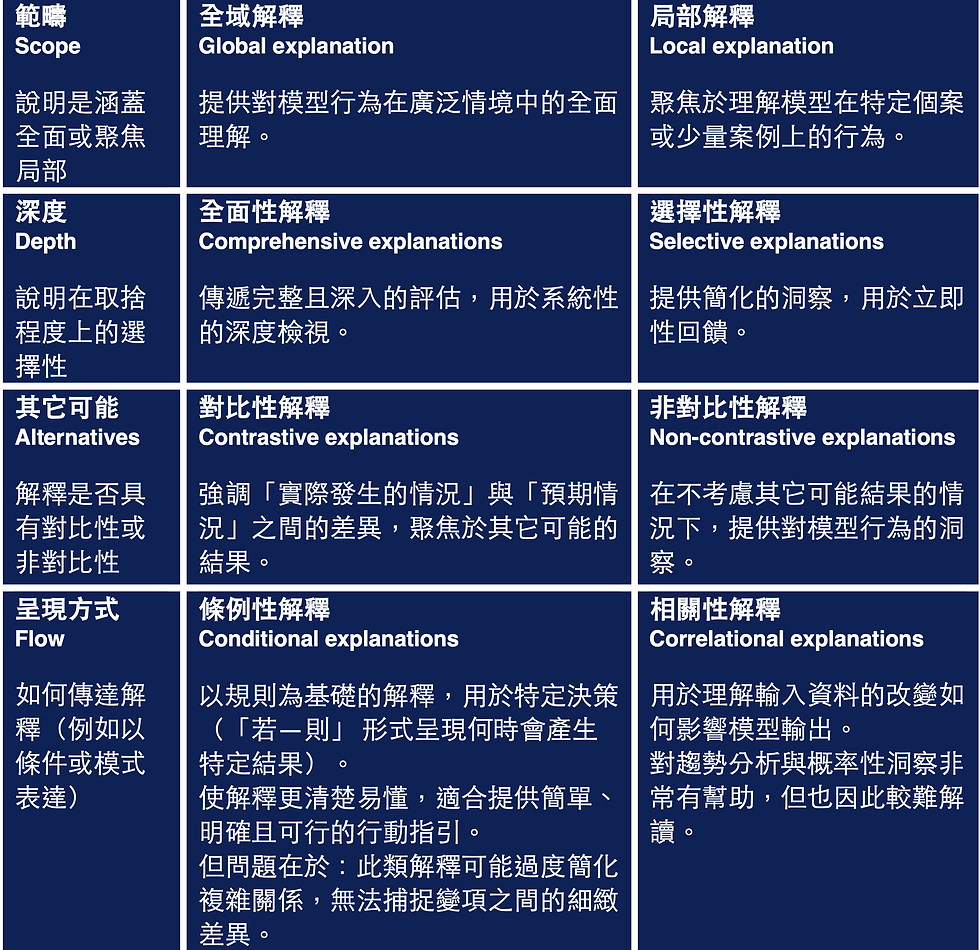

值得注意的是,該報告提出針對教育人工智慧系統解釋力的四個面向(圖二),並運用這四個面向做為工具,建議教育者在可解釋人工智慧上可發展的能力(Bellas, et al., 2025: 86)。

圖2

教育人工智慧系統解釋力的四個面向和兩個層次

圖示說明:為確保人類對人工智慧的監控和共享責任,人工智慧在教育上的發展可以就四個面向和兩個層次來發展其解釋力。這個解釋力架構可以做為人工智慧發展的評估工具,也可以做為教育者專業發展的參照架構。Note: Adopted from Bellas, et al., 2025: 21-22.

歐盟在人工智慧領域上,採用風險基礎和事前原則等主軸進行法制規劃。其目標之一是兼顧創新效律與倫理。這和其他地區在相關領域的發展有許多差異(Butt, 2024; Sloane and Wüllhorst, 2025)。其法制取徑可能在相關標準設立、市場整合與協調整上造成影響。

這份報告回應人工智慧可能帶來的風險,以可解釋人工智慧做為取徑,預視未來教育場域可能地景。報告中除了列出預視的法規基礎和視角依據,也設想了許多可能的腳本,例如自動評分系統和學生作業分析,指出問題和可採取的行動。這些腳本值得讀者進一步思考和設計。

此外,這份報告,也指出治理系統應檢視科技整合教育的假設:融合科技的教育似乎不應止為教師責任,也應從系統與制度對教育實踐的影響來進行設計。制度設計是互動共創的過程,可解釋人工智慧可以做為人工智慧治理發展的其中一個取徑。

參考資料

Carneiro, D., & Veloso, P. (2021). Ethics, transparency, fairness and the responsibility of artificial intelligence. In International Conference on Disruptive Technologies, Tech Ethics and Artificial Intelligence (pp. 109-120). Cham: Springer International Publishing. https://link.springer.com/chapter/10.1007/978-3-030-87687-6_12

Chamola, V., Hassija, V., Sulthana, A. R., Ghosh, D., Dhingra, D., & Sikdar, B. (2023). A review of trustworthy and explainable artificial intelligence (XAI). IEEe Access, 11, 78994-79015. https://ieeexplore.ieee.org/abstract/document/10188681

Butt, J. (2024). Analytical study of the world's first EU Artificial Intelligence (AI)Act. International Journal of Research Publication and Reviews, 5(3), 7343-7364. https://ijrpr.com/uploads/V5ISSUE3/IJRPR24381.pdf

Sloane, M., & Wüllhorst, E. (2025). A systematic review of regulatory strategies and transparency mandates in AI regulation in Europe, the United States, and Canada. Data & Policy, 7, e11. https://doi.org/10.1017/dap.2024.54

Bellas, F., Ooege, J., Roddeck, L., Rashheed, H. A., Skenduli, M. P., Masdoum, F., ... & Obae, C. (2025). Explainable AI in education: fostering human oversight and shared responsibility. https://www.daad-brussels.eu/files/2025/06/EDEH_XAI-Report-1.pdf

若需引用此文章內容,請使用下列APA 7格式:

林宏達(2025年11月30日)。歐盟工作小組提出回應人工智慧風險的一個取徑:可解釋人工智慧(XAI)。教育新知國際串聯。https://www.gel-net.com/post/202511-02